この記事が含む Q&A

- 知的障害のある人はAIで「排除」されてしまうことがあるのですか?

- データ不足と想定対象の偏りが原因で、知的障害のある人が見えなくなる排除が生じ得ます。

- 共につくるデザイン(Participatory Design)とは何ですか?

- 知的障害のある人や支援者を開発チームの正式メンバーとして設け、共に設計を進める方法です。

- デジタル技術をみんなに公平に使えるようにするにはどうすればよいですか?

- 開発・資金・政策の場に知的障害のある人の代表を入れ、わかりやすい資料や使いやすさを重視することが提案されています。

もし、あなたの家族や支援している子どもが、心のことで困っていたとき。

スマートフォンのアプリやAIが、その助けになったらいいな、と思うことがあるかもしれません。

けれども今のところ、その「助け」は、すべての人に平等ではありません。

インドの社会福祉の研究チームが発表した今回の論文は、その理由を静かに問いかけています。

テーマは「知的障害とデジタル精神医療」。

つまり、心の支援をするAIやアプリが、知的障害のある人をどのように扱っているのか――という問題です。

このチームは、インドのマリアン大学とタタ社会科学大学に所属する研究者たちで、社会の中で障害のある人がどう生きていけるかを専門に研究しています。

彼らは今回の論文の中で、デジタルの世界が新しい差別をつくってしまっている現実を指摘しました。

AI(人工知能)を使った精神医療の仕組みは、うつや不安を調べるアプリ、会話で気持ちを聞いてくれるチャットボット、表情から感情を読み取るカメラなど、世界中で広がっています。

でもその多くが「ことばで説明できる人」「頭の回転が速い人」「普通の反応をする人」を前提に作られています。

つまり、AIが想定している“ふつうの人”の中に、知的障害のある人は入っていないのです。

AIの仕組みは、たくさんのデータをもとに学びます。

これを「アルゴリズム」といいます。

しかし、学ぶためのデータの中に、知的障害のある人の声や行動がほとんど含まれていないのです。

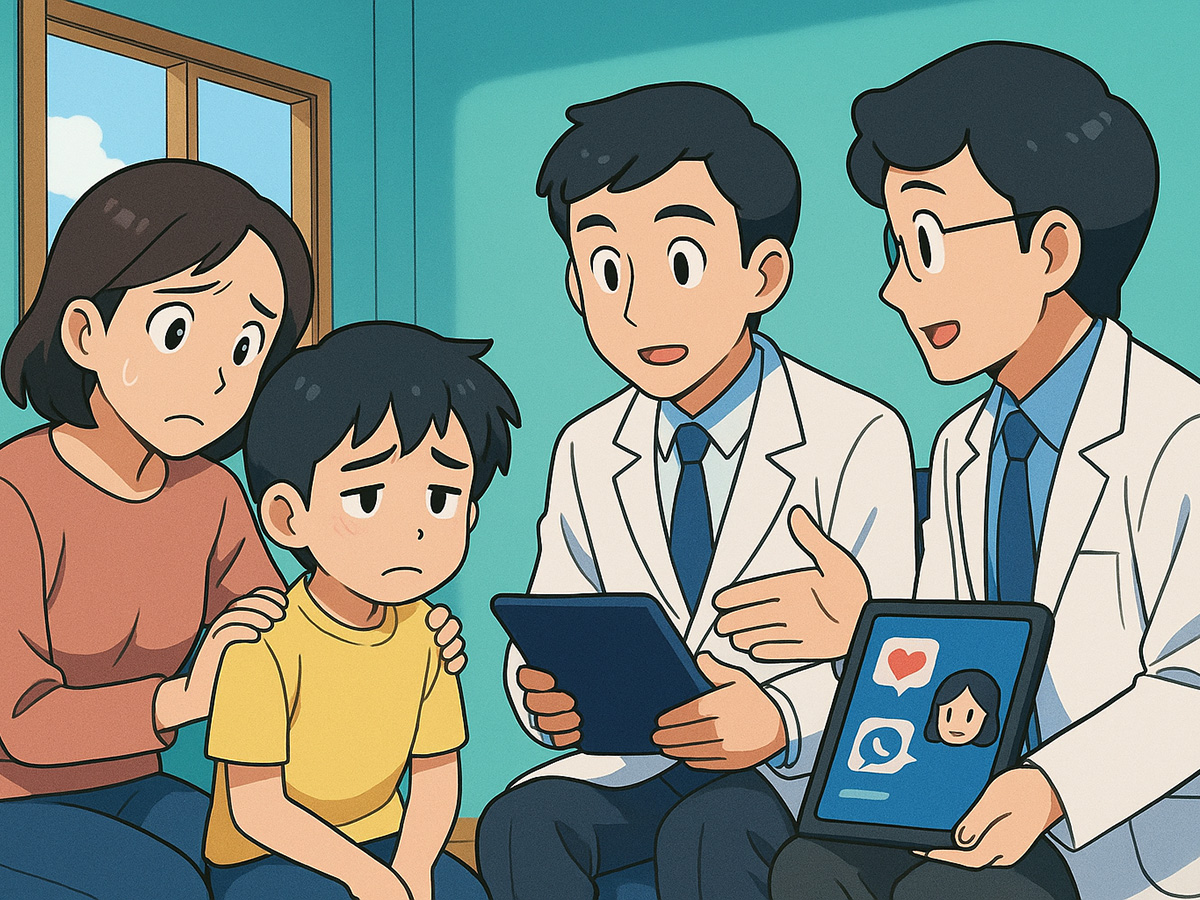

だからAIは、知的障害のある人のことを「知らないまま」判断してしまいます。

たとえば、言葉を選ぶのに時間がかかったり、笑顔が少なかったりすることを、「異常」や「エラー」と決めつけてしまうことがあります。

研究チームは、こうした現象を「アルゴリズムによる排除」と呼びました。

けれども、問題はAIそのものではなく、その作り方にあります。

AIを作る人たちの多くが、「知的障害がある人は対象外」と無意識に考えてしまっていること。

そして、そうした考えのまま設計が進み、「使えない人が出ても仕方ない」と見過ごされてしまうこと。

これこそが本当の問題なのだと、論文は伝えています。

デジタル技術が広がると、「誰でもアクセスできる」と思われがちです。

でも実際には、アクセスできる人が限られている。

この見えない線引きを、研究チームは「認知的公正(Cognitive Justice)」という考え方で説明しています。

「認知的公正」とは、人の考え方や感じ方、学び方の違いを“正しい差”として尊重することです。

AIやアプリを作るときに、「どんな頭の使い方をする人にも通じる仕組み」を考えることが、公正の第一歩だといいます。

しかし現実には、多くのAIは「ふつうの認知の仕方」を中心に作られています。

「質問に答えられること」「文字が読めること」「選択肢から選べること」など、知的障害のある人にとって難しい形が多いのです。

その結果、AIの世界では知的障害者が「存在しないこと」になってしまう。

データの中にも、研究の対象にも、ほとんど登場しません。

研究チームは、こうした排除がさらに連鎖していく危険を指摘します。

AIの学習データにいない → AIが誤って判断する → その結果、支援の対象から外される。

このループの中で、知的障害のある人がますます見えなくなっていくのです。

また、研究の現場でも同じことが起きています。

多くの調査や実験は「ことばで説明できる人」しか参加できません。

そのため、言葉で伝えるのが苦手な人や、時間をかけて考える人は「保護のために除外」されてしまうのです。

それは守るための配慮でもありますが、同時に「あなたの意見はいらない」と言ってしまうのと同じ結果を生みます。

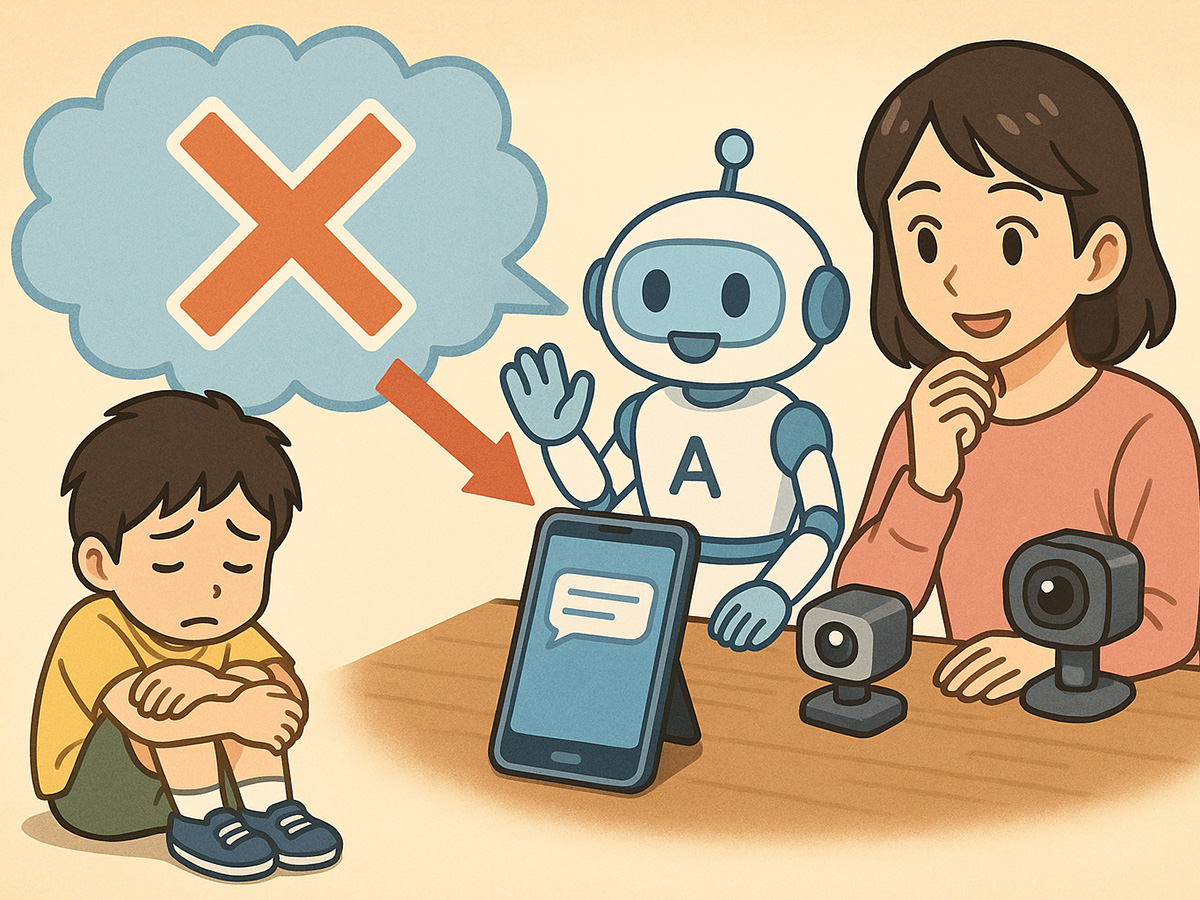

こうした背景のもと、研究チームは、AIの倫理を考えるときに「多様な知のあり方」を中心に置くべきだと訴えます。

たとえば、AIを作るときには、最初から知的障害のある人と一緒に設計をする。

これを「共につくるデザイン(Participatory Design)」といいます。

また、AIの仕組みを見直すときには、「誰が使えるのか」「誰が使えないのか」を具体的に確かめる仕組みを導入する。

こうした方法が、排除を防ぐ最初の一歩になるといいます。

実際、少しずつ世界では変化も見られます。

絵やアイコンを使った画面設計、わかりやすい説明文(イージーリード)、操作を助けるサポートツールなどが試されています。

マイクロソフトの「AI for Accessibility」や、イギリスの「AbleChat」などの取り組みは、単なる「参加」ではなく「共同の開発者」として障害のある人を迎え入れています。

研究チームは、これを「象徴的な参加ではなく、構造的な参加」だと評価しています。

しかし、世界の多くの地域では、まだその道は遠いといいます。

とくに、通信環境が不安定で、スマートフォンを家族で共有する国や地域では、AIを使うこと自体が難しい。

欧米で作られたAIが、そのままの形で導入されると、現地の文化や暮らし方に合わず、かえって使えない人を増やしてしまう。

研究チームは、これを「デジタル植民地主義」と呼び、技術が文化や人を押しつぶす危険を警告しています。

それでは、どうすればよいのでしょうか。

論文は、「文脈に合わせた共同の改革」を提案しています。

その中には、次のような具体的な提案が書かれています。

- AIやアプリを導入するときには、「知的に使いやすいか」を必ず点検する。

- 開発チームの中に、知的障害のある人や支援者を正式なメンバーとして含める。

- 研究の資金を出す側も、「わかりやすい資料」や「共につくる時間」を条件にする。

- 政策を決める会議には、知的障害のある人の代表を入れる。

これらはすべて、AIを「特別な人のためのもの」から、「みんなでつくるもの」に変えるための仕組みです。

研究チームは、こうした取り組みを「最低限の基準」として提案しています。

この論文は、知的障害のある人を「助ける対象」としてではなく、「社会を変える知恵の持ち主」として見ています。

そして、AIの発展は「人間のふつう」を狭くするものではなく、「人の多様さを広げるもの」であるべきだと語っています。

デジタルの世界で、すべての人が「自分の感じ方や考え方のまま」いられるようにする。

それこそが、本当の意味での“やさしい技術”なのかもしれません。

(出典:Frontiers in Psychiatry DOI: 10.3389/fpsyt.2025.1691940)(画像:たーとるうぃず)

うちの子は重度自閉症で知的障害もあり、話すこともできません。

まさに、そう思っていて、あきらめていました。

しかし、こうした考え、視点をもってAIの開発、活用を考えてくだされば、うちの子を助けてくれるようなAI、ロボットの出現も私が思っているより早くなってくれそうです。

遅くとも、わたしがいなくなる前に。

心から、そうなることを期待しています。

(チャーリー)